液浸スモールデータセンターのPoCに見る省エネのブレークスルー

地球環境の保全に向けた長期計画「KDDI GREEN PLAN 2030」を遂行中のKDDIでは、絶縁性のオイルでICT機器を直接冷却する「液浸技術」と12フィートの小型コンテナを活用した「液浸スモールデータセンター」のPoC (注1) (Phase2) を、三菱重工業株式会社様とNECネッツエスアイ株式会社様と共同で進めている。同PoCではすでに、「PUE (注2) 1.07」という高い電力使用効率を達成しており、省エネデータセンターを実現する新しい手法を求める多くの企業・組織の関心と期待を集めている。

- 注1) PoCとは、Proof of Conceptの略称で直訳すると概念実証となる。新しいアイデアやコンセプトの実現可能性や得られる効果などについて検証することを指す。

- 注2) PUE:データセンターの消費電力をICT機器の消費電力で割った数値。「1.0」に近いほどセンターの電力使用効率が高い。

- ※ 記事内の会社名、部署名、役職名は取材当時のものです。

深刻化するデータセンターの電力問題を解決する“液浸”

サービス企画開発本部 プラットフォーム技術部

インフラ基盤2グループ エキスパート

加藤 真人

加速するデジタル化の中で、日々の暮らしやビジネスでのクラウドサービスの利用も活発化し、それがデータセンター需要の大幅な拡大へとつながっている。

「ここ数年来、データセンター需要はみるみる伸びていき、多くの事業者が設備増強を続けています。KDDIでもデータセンターを新設しなければ、ハイペースで伸び続けるデータセンター需要に対応し切れない状況です」と話すのは、KDDI サービス企画開発本部 エキスパートの加藤 真人だ。

こうした中で深刻度を増しているのが、データセンターの電力問題だ。増え続けるデータセンターの電力消費が相当量のCO2排出へとつながり、地球環境に負のインパクトを与えかねない状況になっている。

ただし、この問題を解決するにはデータセンターのキャパシティを上げながら、電力消費を抑えるという相反する条件を整理しなければならない。一般的なデータセンターでそれを実現するのは難しいとKDDI 同本部のコアスタッフ、谷岡 功基は指摘する。

「例えば、サーバーの性能を上げることで機器を集約し収容場所のキャパシティは増やせますが、それによってサーバーのCPUやGPUの排熱処理が難しくなり、結果として冷却により多くの電力が必要とされます」(谷岡)

加えて、ラックへの集積度を高めようとすると、各サーバーの冷却ファンから排出される熱風が隣接したサーバーに影響を及ぼし故障を引き起こしかねない。

サービス企画開発本部 プラットフォーム技術部

インフラ基盤1グループ コアスタッフ

谷岡 功基

「高性能サーバーの場合、実質的な排熱を考えると1ラックに3台までしか収納できず、単体性能をいくら上げても、ラック当たりのキャパシティが一向に増えないといった問題を抱えています」(加藤)

このような問題を抜本的に解決する手段としてKDDIが想起したアイデアが、データセンターにおけるICT機器の冷却方式を「空冷」から「液浸」へと切り替えることだった。

基礎検証でPUE 1.09を達成し

“液浸”の省エネデータセンターにおける効力を実証

前述したとおり、液浸とは電気を通さない絶縁性のオイルによってICT機器を直接冷却する手法だ。各国が威信をかけて開発しているスーパーコンピュータに使われている基盤を冷却する手段として古くから使われており、空冷方式に比べて冷却効率が何倍も高いという特長を持つ。

「液浸技術は一般のデータセンターや汎用のサーバーにあまり使われなかっただけで、技術としては成熟したテクノロジーです。この液浸を用いることで、空冷よりも少ない電力でICT機器が冷却でき、データセンターの電力使用効率を大幅に高められると考えました。そこで、液浸技術を核にPUE値が限りなく『1.0』に近い省エネデータセンターを実現し、CO2排出量の低減に貢献しようと考えました」(加藤)

こうして2020年7月から2021年1月にかけて液浸技術を使ったデータセンターの基礎実証 (PoC Phase1) を台湾で実施した。この実証は、液浸技術と20フィートコンテナ、さらには外気空冷を組み合わせたコンテナ型データセンターを使って行われ、最終的に「PUE 1.09」を達成した。

「これまでのデータセンターのPUE値は1.7〜2.0ですので、PUE 1.09はきわめて優秀な値と言え、この結果によって液浸の有効性が改めて実証されました」(加藤)

三菱重工とNECネッツエスアイとの共同で

省エネデータセンター “Phase2”を推進

台湾での基礎実証で液浸技術の有効性を確認したKDDIは、液浸データセンターの製品化・普及を見据えた「PoC Phase2」の実施に向けて動き始めた。PoC Phase2では、基礎検証から得られたデータや設備設計をベースに排熱能力の向上や設置スペースの削減、日本の消防法・建築基準をクリアするといった目標が定められた。

Phase2の最初のステップは、液浸技術を使った省エネデータセンターの意義と可能性に共感し、ともに推進してくれる日本のパートナーを探すことだ。三菱重工とNECネッツエスアイの2社がメインパートナーとして名乗りを上げ、有力プロセッサメーカーやIT機器メーカーを巻き込んだ「液浸スモールデータセンター」の開発・実証プロジェクトが、三菱重工「Yokohama Hardtech Hub」で立ち上がった。

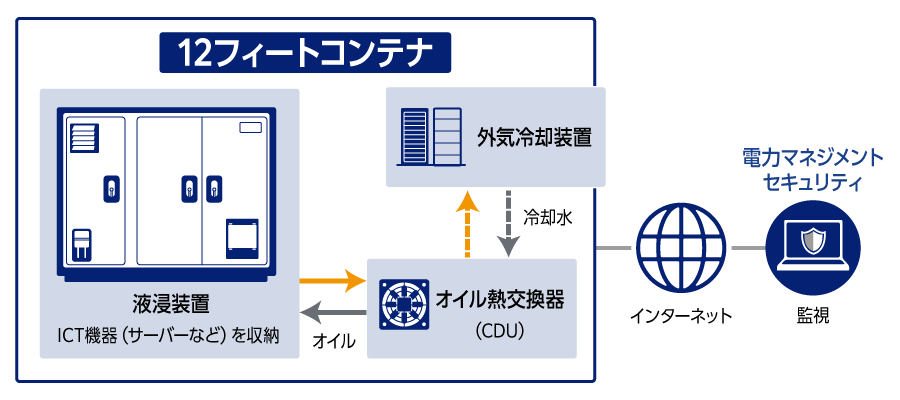

液浸スモールデータセンターは、基礎検証で使われた20フィートコンテナよりさらに小さい12フィートコンテナを使用して作られている。

ICT機器を収納する「液浸装置」、「オイル熱交換器 (CDU)」「外気冷却装置」から成り、そのラックには1Uサイズで最大で24台のサーバーを収納することができる (PoC用として収納されていたのは10台のサーバー)。

ICT機器をオイルで冷却する液浸装置部分 (左側)

オイル熱交換機および外気冷却装置 (右側)

技術戦略推進室 ビジネスインテリジェンス &イノベーション部

MTIグループ 主席部員

磯部 勇介 様

また、オイル熱交換器では、液浸装置内で熱せられたオイルがパイプを通じて循環し、外気冷却装置の冷却水で冷やされた後に再び液浸装置へと戻される仕組みになっている。さらに、外気冷却装置は、ラジエーターと外気空冷用ファンから成り、ラジエーターで外気により直接冷やされた冷却水がパイプを通じて、オイル熱交換器に供給され、オイルと同様に密閉循環している。

この外気冷却装置を含めて液浸スモールデータセンターのファシリティ設計・製造はすべて三菱重工とNECネッツエスアイが担っている。

「12フィートのコンテナ内は想像以上に狭く、そこに液浸装置や外気冷却の機構を入れ込むのは難しかったのですが、発電プラントで培った配置・空間設計や、冷熱機器の冷却設計に関する当社のノウハウがうまく生かせたと感じています」(三菱重工 技術戦略推進室 磯部 勇介様)

「PUE 1.07」を達成し、さらに膨らむ期待

液浸スモールデータセンターが、PUE 1.07という高い電力使用効率を実現できた要因の1つは、オイルの上限温度設定が60度にされている点にある。

「60度は外気温が35〜40度となってもオイル冷却装置に外気空冷ファンだけで担保できるオイル温度です。つまり、この高めの温度設定によって、オイル冷却の電力消費を小さく保てるわけです」と加藤は説明を加える。

また、オイル温度が60度でもサーバーは安定稼働を続けると谷岡は指摘し、以下のように説明を続ける。

「液浸装置内であれば、オイルが60度でも従来の空冷と異なり熱伝導率が高く冷却効率が良いのでサーバーは安定して動き続けます。ただし、汎用のサーバーでは安全に稼働させるため、稼働保証温度50℃程度でサーバー稼働の制限を設けています。そこで、サーバーメーカーにファームウェアを変更してもらい、オイル温度が60度超に達するまでサーバー稼働が制限されないようにしています。また、液浸装置内には空冷ファンが不要となるので、その分の電力が削減されるというメリットも生まれます」(谷岡)

さらに、電力の使用効率を高める仕組みを備えている。NECネッツエスアイと三菱重工が共同で開発した電力マネジメントシステムだ。Zabbix (注3) と汎用的なDCIMシステム (注4) を組み合わせすることにより統合的な監視・制御も実現している。

「このシステムは、サーバー内各パーツの温度を細かくモニタリングし、温度がしきい値を超えた際には信号を送り、ラジエーターやポンプ、外気空冷用ファンなどを自動的に制御する仕組みです。これによって、サーバーの負荷状況に合わせて、PUEをバランスよく下げていくことが可能になります」とNECネッツエスアイ エンジニアリング&サポートサービス事業本部のグループマネージャー 松田 光昭 様は説明する。

液浸スモールデータセンターで使われている液浸装置は、すでにKDDIのデータセンターで試験的に導入されることが予定されている。このように、液浸の技術がコンテナだけではなくデータセンターに導入されることは、加藤が構想していることの一つだ。

エンジニアリング&サポートサービス販売推進本部

グループマネージャー

松田 光昭 様

「液浸技術と外気空冷の組み合わせが、電力使用効率のアップにきわめて有効であることはPoCを通じて実証されています。しかも、液浸装置は通常のラックに比べてサーバーの集積率が高く、静音性にも優れています。今後は、こうしたメリットを訴求しながら、データセンターでの利用を促進したいと願っています」(加藤)

一方、コンテナ型の液浸スモールデータセンターについても、自治体や臨時のイベント会場、工場での利用など、さまざまな可能性があり、加藤はそれにも期待を寄せている。屋外設置にはセキュリティ面の対応が必要となるため、NECネッツエスアイでは、高精度の「顔認証」を用いた入退室制御など、実際の使用を想定したセキュリティソリューションの提供も計画している。

「これからもデータセンター需要は増えていくことは間違いなく、東京ではすでにデータセンターの密集が問題視され、地域への分散化が必要とされはじめています。こうした中で、従来型の冷却アプローチを踏襲し続けると、電力の問題に必ず突き当たります。そのとき、液浸というキーワードを思い出してほしいと願っています」(加藤)

液浸によって、データセンターの省エネ化の新しい道筋が切り拓かれる日は近い。

- 注3) Zabbix:サーバー、ネットワーク、アプリケーションを集中監視するためのオープンソースの統合監視ソフトウェア。

- 注4) DCIMシステム:データセンター インフラストラクチャ マネジメント。消費電力や温度、湿度を測定し空調のコントロールや機器の稼働状況把握、異常の検出をするシステム。